まますさん

@mamas16k

Followers

6,707

Following

5,208

Media

856

Statuses

54,426

kgs出身のシナモン/囲碁(野狐8段)/Kaggle Grandmaster(🥇0🥈2🥉1)/フォロー返し間に合ってません/発言は私の見解ではありません

kgs go server

Joined December 2010

Don't wanna be here?

Send us removal request.

Explore trending content on Musk Viewer

Cheney

• 316130 Tweets

Eagles

• 174959 Tweets

Uruguay

• 60662 Tweets

Suárez

• 51307 Tweets

श्री गणेश

• 48849 Tweets

#SmackDown

• 48519 Tweets

Saquon

• 44968 Tweets

Peacock

• 40904 Tweets

Giants

• 40803 Tweets

गणपति बप्पा

• 39104 Tweets

1 Day Left For Avataran Diwas

• 38793 Tweets

Jalen

• 37034 Tweets

Green Bay

• 32218 Tweets

Paraguay

• 28232 Tweets

Philly

• 27990 Tweets

#GaneshChaturthi

• 26876 Tweets

#GBvsPHI

• 26122 Tweets

#GoPackGo

• 16078 Tweets

Lord Ganesha

• 13754 Tweets

#二度と撮れない画像を貼れ

• 13025 Tweets

Jayden Reed

• 11662 Tweets

Fritz

• 11579 Tweets

Jordan Love

• 11108 Tweets

Tiafoe

• 10864 Tweets

BOSSNOEUL Q5 TBNW

• 10783 Tweets

Lucho

• 10740 Tweets

Lynx

• 10416 Tweets

Wisdom & Prosperity

• 10020 Tweets

Last Seen Profiles

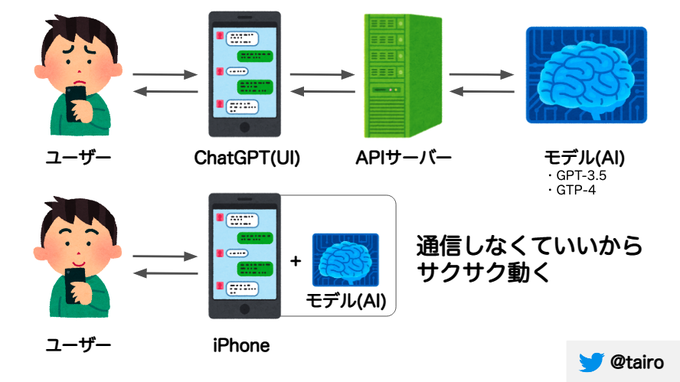

超有能な同期のTransfomerまとめ記事です!!!

かなり読み応えのある内容になってますので、ChatGPT等でTransformerに興味を持った方はぜひご覧ください 🙇♂️🙇♂️🙇♂️

📣ZENKIGEN技術ブログを更新📣

『30分で完全理解するTransformerの世界』

Transformerという深層学習のモデルをこれでもかというほど解説しています!💥

データサイエンティストの方やディープラーニングに興味がある方、ぜひご覧ください。

#survey

#transformer

0

93

548

0

25

215