Tim Salimans

@TimSalimans

Followers

4,894

Following

393

Media

11

Statuses

116

Explore trending content on Musk Viewer

Border Czar

• 568424 Tweets

Nigéria

• 210012 Tweets

Wolverine

• 164437 Tweets

Jasper

• 143647 Tweets

Newsweek

• 132668 Tweets

Nodal

• 73385 Tweets

Alberta

• 68518 Tweets

Padres

• 66103 Tweets

Marta

• 51881 Tweets

Lorena

• 42092 Tweets

スペイン

• 31999 Tweets

Fields

• 30300 Tweets

Bordeaux

• 23572 Tweets

renjun

• 21178 Tweets

#انصفوا_النصر_يالاستقطاب

• 14167 Tweets

Orioles

• 12717 Tweets

Dylan Cease

• 11813 Tweets

Gabi Nunes

• 11498 Tweets

Tuğba

• 11335 Tweets

Cancel Netflix

• 10423 Tweets

Last Seen Profiles

Very happy to release

#ImagenVideo

today! Amazing work with an amazing team!

High fidelity text to video with diffusion models: "Flying through an intense battle between pirate ships in a stormy ocean."

Excited to announce Imagen Video, our new text-conditioned video diffusion model that generates 1280x768 24fps HD videos!

#ImagenVideo

Work w/

@wchan212

@Chitwan_Saharia

@jaywhang_

@RuiqiGao

@agritsenko

@dpkingma

@poolio

@mo_norouzi

@fleet_dj

@TimSalimans

58

734

3K

22

187

1K

Diffusion models can now produce great samples in as few as 4 sampling steps, as

@hojonathanho

and I show in our new paper (ICLR spotlight):

🧵 1/

4

79

480

Looking forward to my first ICML as a Googler, working alongside Lasse Espeholt and

@NalKalchbrenner

at a new Google Brain office in Amsterdam!

#ICML2018

#GoogleBrain

9

27

263

Our paper on implicit generative models for speech synthesis is out! We use a spectrogram-based loss like DDSP and OpenAI Jukebox, but add a repulsive term that offers statistical guarantees:

w/

@agritsenko

@vdbergrianne

@NalKalchbrenner

@latentjasper

1/3

1

50

253

We have a new distillation method that actually *improves* upon its teacher.

Moment Matching distillation () creates fast stochastic samplers by matching data expectations between teacher and student.

Work with

@emiel_hoogeboom

@JonathanHeek

@tejmensin

.

1/4

7

35

191

Diffusion-based generative models are SOTA on perceptual quality, but how good are they at density estimation? Very good it turns out!

📢Announcing our new paper on diffusion models, with SOTA likelihoods & compression + new theoretical insights into this exciting model class.

New paper: Variational Diffusion Models (VDMs)!

✅ New general insights into diffusion models

✅ Simple objective

✅ Fast optimization & anytime synthesis

✅ SotA likelihoods & lossless compression

Work with

@TimSalimans

@poolio

@hojonathanho

(1/n)

8

108

565

2

26

168

With a simple modification to the noise schedule, diffusion models now work directly at high resolutions without requiring cascades or latents!

And it's fast too: 0.4 seconds to generate an image using our distilled model.

Check out the paper with

@emiel_hoogeboom

&

@JonathanHeek

If diffusion models are so great, why do they require modifications to work well? Like latent diffusion and superres diffusion?

Introducing "simple diffusion": a single straightforward diffusion model for high res images () . w/

@JonathanHeek

@TimSalimans

5

65

398

2

13

106

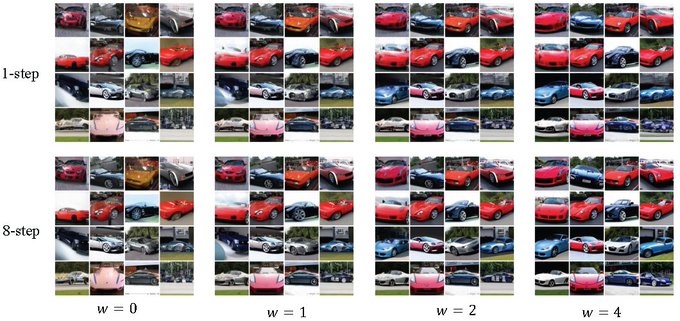

New work on distillation of diffusion models 📢

Getting closer to zero loss in quality than ever before, while needing only 4-16 sampling steps.

Bonus content: a new deterministic sampler - aDDIM - generalizing DDIM and performing substantially better!

Fast sampling with 'Multistep Consistency Models': We get 1.6 FID on Imagenet64 in 4 steps and scale text-to-image models, generating 256x256 images with 16 steps.

Guess which row is distilled?

With

@emiel_hoogeboom

@TimSalimans

Arxiv:

2

19

86

0

4

41

Progressive distillation now works for classifier-free guided diffusion models and stochastic samplers! Excited to share this work with Chenlin and other collaborators on how to make diffusion models fast to sample.

0

5

25

@iclr_conf

@dpkingma

Congratulations

@dpkingma

and

@wellingmax

! They couldn't have made a better choice.

0

0

23

@cinjoncin

@OpenAI

We thought this result would be best presented as a blog post + code release, rather than a formal paper.

3

0

18

@emiel_hoogeboom

@JonathanHeek

oops dropped a k there: That's my highly valued colleague Thomas Mensink

@tejmensink

of course!

0

0

7

@PieterOmtzigt

Onjuist: gemiddeld tarief is weldegelijk progressief. Marginaal tarief is degressief, wat inherent is aan veel herverdeling (toeslagen). Die specialist krijgt als "ondernemer" mogelijk voordeel waar je wel wat aan mag doen.

0

0

6

@Zergylord

@cinjoncin

@OpenAI

It's a cherry picked training run, although I have also seen some runs do slightly better still. Variance between trained models is substantial.

0

0

5

@FTM_nl

Dat het allemaal bij deze eigenaren neerslaat is natuurlijk niet eerlijk, maar dat gemeenten in één klap meer dan 100 miljoen aan waarde kunnen creëren op onze woningmarkt met het doorstrepen van één beperkende regel zegt wel iets over de potentie van verdere liberalisatie, niet?

1

0

4

Great progress in getting denoising models to work for image generation!

New paper on diffusion probabilistic models with

@ajayjain318

&

@pabbeel

:

Likelihood-based generative model with SOTA FID=3.17 on unconditional CIFAR10, and ProgressiveGAN-like quality on 256x256 LSUN & CelebA-HQ (sometimes generates dataset watermarks!)

6

136

450

0

0

4

@Lukkezen

Niet structureel maar eenmalig toch? (Cumulatief tot er een ander systeem is) De complete box 3 opbrengst is nu maar 4 miljard per jaar, dus lijkt me dat het verlies nooit zoveel kan kosten als 800 euro pppj zoals je beschrijft?

1

0

3

@roydanroy

On CIFAR10 with data augmentation we get 2.49 bits per 8 bits of original data, so about a 70% reduction. That seems good in an absolute sense? Also images are highly structured, so the curse of dimensionality doesn't quite apply.

1

0

3

Nice demonstration of JAX/Flax, showing how easy it makes things like data dependent parameter initialization.

0

0

3

@Menno_Snel

Forse belastingverhoging voor beleggers, vermomd als cadeau voor spaarders. De commissie parameters (Dijsselbloem) voorziet een reëel rendement van 3.7% op aandelen. Hiervan gaat straks de helft naar de belasting. Prima, maar vergoedt u dan ook de helft van eventuele verliezen?

0

0

3

@StefanTT

@rob_beurskens

De grondkosten.

Toestemming om te bouwen is conditioneel op een bepaalde mix aan goedkoop/midden/duur. Het project in totaal moet winstgevend zijn voor uitvoering, maar de individuele categorien daarbinnen niet noodzakelijk.

1

0

2

@Woningnieuws

Jubeltonnen gegeven in 2022 mogen in 23 en 24 gewoon nog worden besteed volgens mij. (Bestedingstermijn is 3 jaar) Dus geen reden voor haast met kopen?

1

0

2

@Woningnieuws

In de VS wordt veel gebouwd, hier heel weinig. Belangrijker nog, wij dempen het effect van de rente veel sterker via HRA.

0

0

1

@jesseklaver

Zeer misleidend. Uitgestelde belasting wordt niet meegerekend. Wanneer die belasting uiteindelijk wel wordt betaald (bijvoorbeeld na pensioen of overlijden) is het inkomen vaak lager of niet aanwezig, en valt dezelfde persoon dus niet meer in de hogere percentielen.

0

0

0

@CliffordAsness

Presumably the assumption is that the fed's response to any financial instability will be to again throw the kitchen sink at it like they did in the covid crash? That turned out to be very bullish for both equities and bonds.

0

0

1

@jeremyphoward

@leriomaggio

@OpenAI

@fchollet

You would need access to the previous layer's weights, which Keras doesn't give you.

1

0

1

@mathijsbouman

Is naast die onverstandigheid van blind vertrouwen ook niet de les dat je dingen niet geheel gratis moet maken voor de consument? Bij de oude regeling (belastingaftrek) betaalde je iig de helft zelf: dan denk je wel een keer extra na voordat je een nutteloze cursus aanschaft.

0

0

1

@StefanTT

Per vierkante meter is de daling echter maar 4.1% in Amsterdam. Veel kleinere woningen verkocht dus, mogelijk vooruitlopend op regulering vrije sector huur?

0

0

1

@jvanwensen

15.

Meetkundig gemiddelde = exp((log(eind)-log(start))/duur).

In de brief staat iets heel anders, maar ik weet niet wat de belastingdienst daadwerkelijk in de berekeningen gebruikt. Lijkt alsof ze uitgaan van een soort exponential moving average?

0

0

1

@_basjacobs

Volledig mee eens, maar wat doe je met de ongelijke toegang tot vrijgestelde pensioenfondsen? De één kan nu 30% opzij zetten (pensioenfonds) en de ander maar 13% (jaarruimte), waarbij die eerste bovendien de volledige marginale belasting + premies terugkrijgt en die tweede niet.

0

0

1

@Woningnieuws

@StefanTT

Toch stijgt het gemiddeld verdiende salaris in NL gewoonlijk nog sneller dan dit cao cijfer: mensen wisselen van baan, hebben geen cao, of krijgen er automatisch een periodiek bij. In tijden van krapte gaan vooral de baanwisselaars en flexibele arbeid er flink op vooruit.

1

0

1

@Lukkezen

"lagere prijzen" is geen doel opzich. Is het doel om koopkracht te verschuiven van huizenbezitters naar anderen dan is het minder verstorend om huizenbezit te belasten. Is het doel woningen bereikbaarder te maken voor lage inkomens dan is inkomensondersteuning minder verstorend.

2

0

1

@_basjacobs

Mooi voorstel. Mogelijke toevoeging: bij afrekenen gerealiseerde winst corrigeren voor inflatie. Het tarief op reëel rendement kan je dan gelijk stellen met dat op arbeid wat arbitrage voorkomt, en het pakt eerlijker uit bij hoge inflatie zoals nu.

0

0

1

@StefanTT

@rob_beurskens

Ja klopt allemaal. En heeft allemaal goede redenen. Maar wel belangrijk om deze kosten voor de samenleving mee te rekenen bij het maken van beleid. Anders heeft (vrije markt) woningbouw steeds het nakijken en krijg je een enorm woningtekort. Zoals nu dus.

1

0

1